Die richtige Vorgehensweise beim A/B-Testing

Eine bewährte Methode um die Usability und damit die Conversion-Rate eines Shops zu optimieren ist das A/B-Testing. Hierbei werden mehrere Webseiten-Varianten an die Besucher ausgespielt und so gegeneinander getestet. Inzwischen kann mithilfe von Software-Lösungen ein A/B-Test in wenigen Minuten gestartet werden. Klingt einfach, birgt aber einige Stolperfallen, die es zu verhindern gilt.

Ohne Strategie, kein A/B-Testing

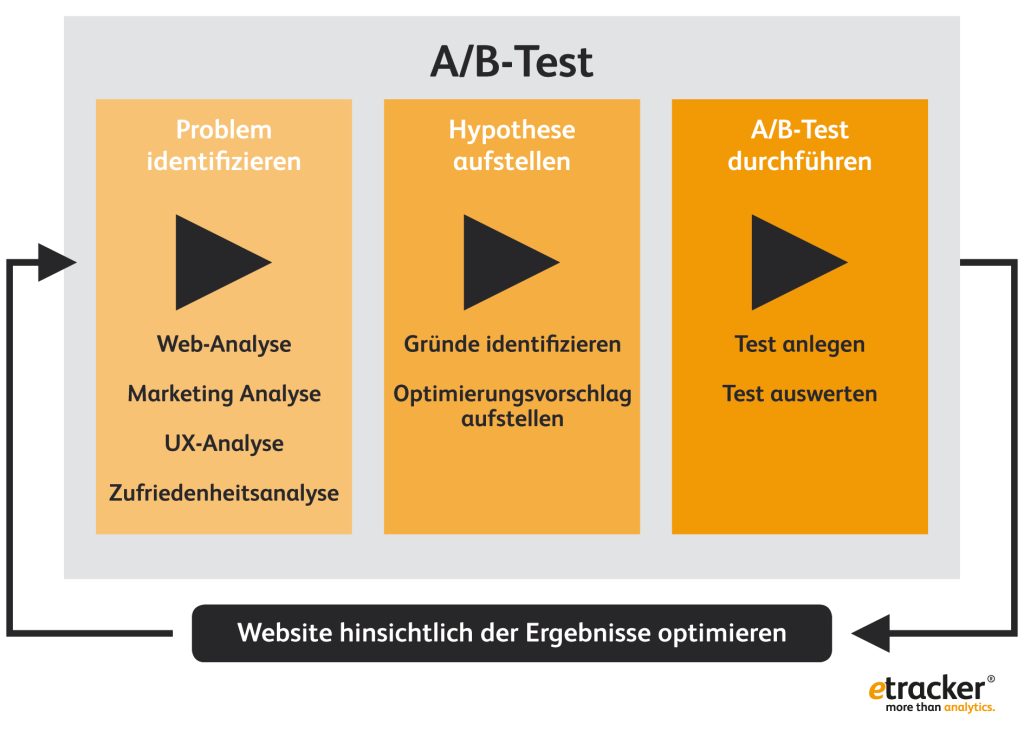

Mit modernen Tools können A/B-Tests im Handumdrehen erstellt werden. Das verführt Marketingverantwortliche dazu, mal eben noch eine Seitenvariante zu erstellen, ein Ziel zu formulieren und den Test zu starten. Was dabei häufig vergessen wird, ist der strategische Ansatz vor dem Aufsetzen des Tests, denn zunächst muss das Problem identifiziert werden. Hinweise dafür können zum Beispiel aus der Web-Analyse oder Zufriedenheitsabfragen kommen. Im zweiten Schritt identifiziert man die Gründe für das Problem und stellt eine Hypothese auf. Nur dann kann der folgende A/B-Test richtig gemessen und bewertet werden.

Die Hypothese wird wie folgt formuliert: „Wenn ein <Problem> durch <Optimierungsvorschlag> verändert wird, erreichen wir eine Verbesserung von <erwartetes Ergebnis>.“

Vermeiden Sie den Fehlerteufel

Aus der einfachen Bedienung von A/B-Testing-Tools ergibt sich noch eine weitere Stolperfalle: der Fehlerteufel. Einmal nicht aufgepasst und schon wird der Test beispielsweise für alle Produkte im Shop ausgespielt statt nur auf einer Produktseite. Oder noch schlimmer: Die angelegte Seitenvariante ist fehlerhaft und anstelle einer geänderten Schriftfarbe, wurde der ganze Produktpreis um eine Kommastelle verschoben. Auch wenn A/B-Tests heute schnell erstellt werden können, gilt die Devise: Schritt für Schritt vorgehen und vor dem Release des Tests noch einmal explizit die Funktionalität sowie unterschiedliche Browser, Auflösungen und Endgeräte kontrollieren.

Definieren Sie konkrete Ziele

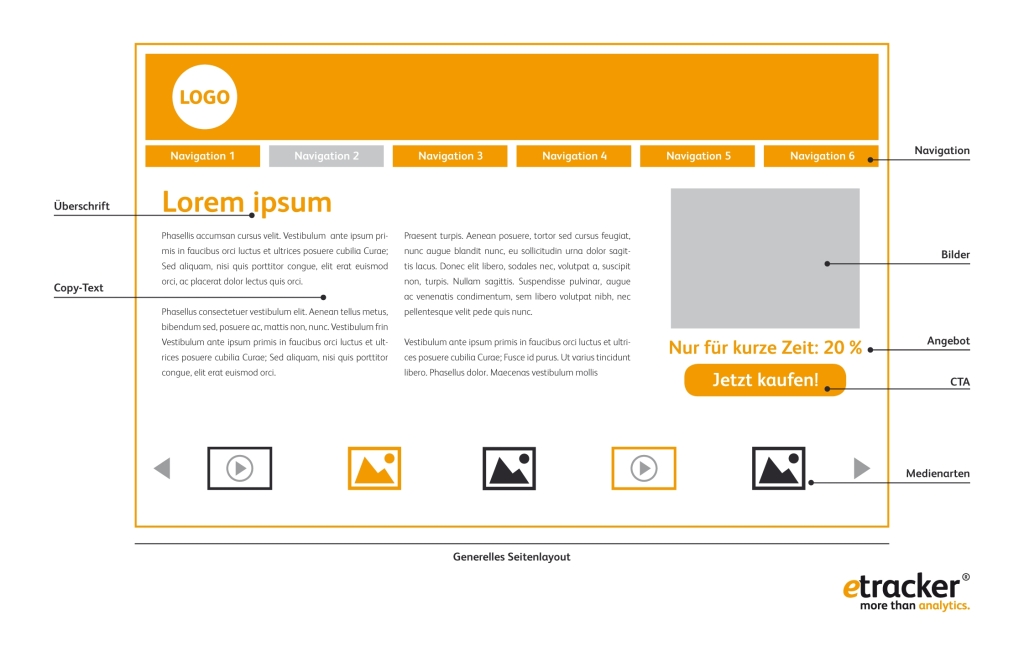

Ein A/B-Test kann nur ausgewertet werden, wenn ein Ziel vorliegt, das erreicht werden soll. Bei der Zielsetzung gilt es, mit Bedacht und Planung vorzugehen. Selbstverständlich möchte man als Marketingverantwortlicher, Shop- oder Websitebetreiber nach einem A/B-Test mehr Produkte verkaufen. Den erhöhten Umsatz als Ziel für die Konversion eines kleines Website-Elements, wie Call-to-Action-Buttons, anzugeben, kann den Test allerdings verfälschen. Zu viele Faktoren wirken auf den Verkauf ein. Online-Marketer sollten sich daher Mikro-Conversions als Ziele setzen. Das bedeutet: Kürzere Conversion-Ziele sind aussagekräftiger als längere. Im Fall des Call-to-Action-Buttons kann das Ziel einfach der Klick darauf sein. Diese Mikro-Conversion liefert bessere Hinweise, ob eine Variante funktioniert als etwa die Anzahl der dadurch generierten Bestellungen.

Das A/B-Testing sollte den Google-Richtlinen entsprechen

Obwohl sich ein gutes Suchmaschinenranking über einen langen Zeitraum etablieren muss, kann es durch A/B-Tests auch schnell wieder vernichtet werden. Es reicht, wenn der Test falsch ausgesteuert wird und die beiden Seitenvarianten von Google damit als Duplicate Content behandelt und abgewertet werden. Achten sie deshalb immer darauf, dass die Seitenvarianten Google-konform ausgesteuert werden. Dies ist beispielsweise möglich, indem man bei A/B-Tests den Content der Seite dynamisch ändert und der Google-Crawler immer nur die Originalseite zu Gesicht bekommt. Verwenden sie einen „Canonical Tag“ bei einem Split-URL-Test, bei dem es zwei oder mehr physikalische Seiten gibt, die gegeneinander getestet werden sollen. Er weist Google auf den Original-Content hin.

Die Datenmenge muss groß genug seien

Um einen A/B-Test auszuwerten, benötigt man Daten über die Konversion oder das Engagement auf den einzelnen Seitenvarianten. Auch wenn sich nach 100 Testbesuchern schon ein Gewinner herauskristallisiert, sollte das Testing nicht sofort beendet werden. Die Datenmenge muss groß genug sein, um die Gewinner-Variante mit statistischer Signifikanz zu bestimmen. Typischerweise sind es einige 100 bis einige 1000 Besucher pro Test, abhängig davon, wie stark sich die Conversion-Rate der Seitenvarianten vom Original unterscheidet. Erst bei einem signifikanten Ergebnis kann ein A/B-Test beendet und die erfolgreiche Variante umgesetzt werden. Hier zeigen sich auch die Vorzüge dieser Methode gegenüber dem multivariaten Test. Letztere haben eine große Anzahl an Varianten, was die benötige Datenmenge drastisch erhöht.

Aktivieren Sie einen Autopiloten beim A/B-Testing

Ein A/B-Test kann manchmal schneller ein eindeutiges Ergebnis erzielen, als man vermutet. Und mit jedem Tag, an dem er noch läuft, obwohl bereits eine erfolgreiche Seitenvariante identifiziert wurde, büßt der Websitebetreiber Umsatz oder zumindest die definierten Conversion-Ziele ein. Es empfiehlt sich deshalb, einen Autopiloten beim A/B-Testing einzustellen. Er erkennt, wenn es eine eindeutige Gewinnervariante gibt, und spielt diese mehrheitlich aus.

Führen Sie eine Segmentierung durch

In der Regel werden A/B-Testings über alle Kundengruppen einer Website oder eines -shops gefahren. Der Marketingverantwortliche sieht sich mit einer Gewinnvariante konfrontiert. Allerdings sollte er die Ergebnisse immer segmentieren. Gibt es Auffälligkeiten bei den Wiederkehrern, Stammkunden, Besuchern, die von Facebook kommen? Möglicherweise funktioniert für eine Gruppe die Originalseite besser, für andere eine Seitenvariante. So bekommt man über das A/B-Testing auch einen ersten Einblick in mögliche Personalisierungsstrategien. Je nach Besuchergruppe und Verhalten können dann verschiedene Websiteinhalte automatisch ausgespielt werden.

Kommentare